Nos últimos anos, os avanços em Inteligência Artificial (IA), especialmente com sistemas como ChatGPT, Gemini e Copilot, impressionaram as pessoas. Eles respondem a perguntas com fluência, explicam conceitos complexos, produzem textos bem articulados e até afirmam “pensar” sobre determinadas questões. No entanto, essa aparência de raciocínio é apenas isso: aparência. Por trás da linguagem convincente, não há consciência, compreensão nem pensamento real.

- IA mostra por que alguns pacientes respondem a tratamentos e outros não

- Take a break | Se o ChatGPT sugerir uma pausa, pare porque é para o seu bem

As chamadas IAs generativas funcionam com base em modelos de linguagem de larga escala que têm um funcionamento matemático e estatístico. Esses sistemas são treinados com enormes volumes de texto e, a partir disso, aprendem a prever a próxima palavra mais provável em uma sequência. Ou seja, quando um modelo responde a uma pergunta, ele não está raciocinando, está apenas completando frases com base em padrões aprendidos.

O que parece uma linha de raciocínio estruturada, na verdade, é uma cadeia de predições. A IA gera cada palavra considerando quais são as mais prováveis de aparecer depois da anterior, e assim por diante. Isso pode parecer pensamento lógico, mas é apenas processamento probabilístico de linguagem.

–

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

–

Por que parece que a IA “pensa”

A ilusão de que esses sistemas pensam como humanos é reforçada pela linguagem que usam. Frases em primeira pessoa, como “estou analisando” ou “vou considerar isso”, ativam uma tendência natural do ser humano: a de projetar emoções, intenções e pensamentos em qualquer coisa que se comunique de forma parecida com a gente. Esse fenômeno é chamado de ilusão antropomórfica.

Nosso cérebro está programado para interações sociais, então tendemos a interpretar fluência verbal como sinal de inteligência ou consciência. No entanto, os modelos de IA não têm emoções, intenções, senso de ética ou qualquer experiência no mundo físico. Eles apenas simulam linguagem com base em dados.

Filosofia ajuda a entender o que é “pensar”

Desde a Grécia Antiga, filósofos como Platão e Aristóteles já debatiam o que é o pensamento verdadeiro. Platão falava sobre diferentes níveis de compreensão, sendo o mais elevado aquele que envolve intuição e conexão com verdades profundas. Aristóteles também associava o pensamento à experiência sensorial, ao julgamento ético e à sabedoria prática, elementos que surgem da vida em sociedade.

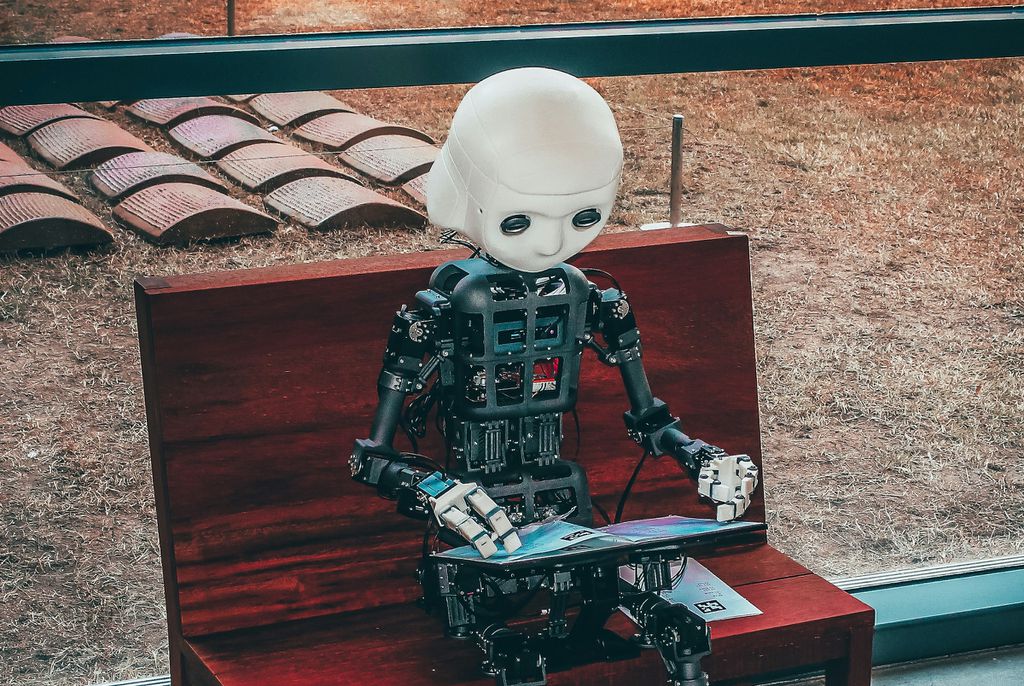

Com isso em mente, fica mais claro por que a IA não pensa. Mesmo que um robô possa ter um corpo físico, ele não tem vivências reais. Ele não sofre, não aprende com erros como um humano, e não forma valores morais. Ele não possui o que Aristóteles chamaria de phronesis: a sabedoria prática que guia nossas decisões com base em ética e experiência de vida, a prudência.

Riscos e consequências da confusão

Acreditar que a IA realmente pensa é perigoso. Isso pode levar à supervalorização de suas capacidades, especialmente em tarefas que exigem julgamento crítico, empatia ou bom senso.

Sistemas de IA têm limitações claras: cometem erros factuais, “alucinam” informações, mantêm mal o contexto em conversas longas e não sabem diferenciar verdade de falsidade com autonomia.

Leia também:

- Terapia no ChatGPT oferece riscos e preocupa o Conselho Federal de Psicologia

- Cientistas da USP conseguem medir a agressividade de 11 tipos de câncer com IA

VÍDEO | O Gemini é muito bom (e isso é um problema)

Leia a matéria no Canaltech.